M4 Mac miniで「gpt-oss」は動く? 動作が確認できたローカルLLMは……:“超”初心者向けローカルAI「gpt-oss」導入ガイド(5)(5/5 ページ)

画像の読み込みもM4 Mac mini 16GBで実現可能に!

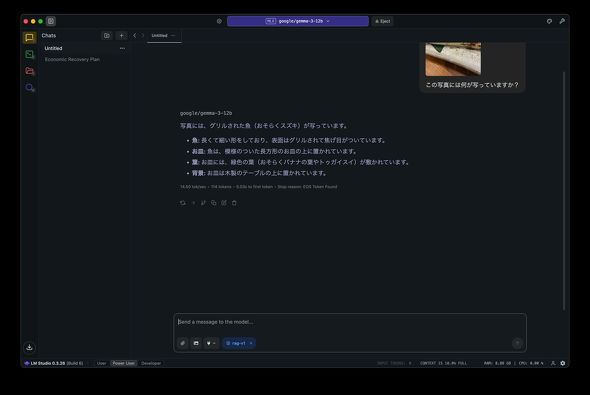

gemma-3-12bはgpt-oss-20bと違ってテキストデータだけでなく、画像データも扱えるため、例えば写真に写っている物が何かチャットで聞いてみることも可能だ。

とはいえ、独立GPUを搭載していないM4 Mac mini 16GBで果たして快適に動作するのだろうか。

先日、居酒屋で注文したサンマの塩焼きの写真が手元にあったので、M4 Mac miniにgpt-3-12bを読み込んで、「この写真には何が写っていますか?」とプロンプトを実行してみた。結果は以下の通りだ。

結果としては、下記の通り写真の内容をおおよそ理解できていることが確認できた。

- 写真には、グリルされた魚(おそらくスズキ)が写っています。

- 魚:長くて細い形をしており、表面はグリルされて焦げ目がついています。

- お皿:魚は、模様のついた長方形のお皿の上に置かれています。

- 葉:お皿には、緑色の葉(おそらくバナナの葉やトゥガイスイ)が敷かれています。

- 背景:お皿は木製のテーブルの上に置かれています。

残念ながらサンマではなく「おそらくスズキと認識する」「トゥガイスイと聞いたことない、検索しても出てこないワードが出てきている」など少し残念な点もあるものの、非常に雑なプロンプトにもかかわらず、しっかりと画像の中身を認識してくれている。

回答自体も14.5トークン毎秒で出力されており、画像認識においても快適に利用できることが分かった。

gpt-oss-20bは利用できないが、M4 Mac mini 16GBでもローカルLLMを十分楽しめる!

今回M4 Mac mini 16GBと、Apple Siliconが搭載されたmacOSデバイスの中で一番安価なモデルを使って試してみた。

gpt-oss-20bのようにパラメータ数が大きいモデルは読み込めないが、gemma-3-12bのように比較的パラメータ数が小さいモデルであれば、難なく利用できることが分かった点は非常に大きい。

ローカルLLMは独立GPUが必須だ、という先入観をもたれがちだが、ユニファイドメモリを搭載した最新のApple Siliconモデルを搭載したmacOSデバイスでもローカルLLMを問題なく利用できる。

今回は詳しく試してはいないが、Windowsデバイスにおいても内蔵GPUのパフォーマンスが一昔前と比べて格段に向上しており、搭載するメモリ量を増やせば、WindowsノートPCでもローカルLLMを十分に利用できることが確認できている。

比較的新しいモデルが必要にはなるが、内蔵GPUのPCでもローカルLLMを楽しめるので、手元のPCにLM Studioをインストールして実際に試してみてはいかがだろうか。

関連記事

テキストだけじゃない? 画像データも理解できる「VLM」(視覚言語モデル)を導入する方法

テキストだけじゃない? 画像データも理解できる「VLM」(視覚言語モデル)を導入する方法

本連載ではローカルLLMの導入方法から活用方法に至るまで、「手元にハイエンドPCがあって、生成AIをローカル環境で動かしてみたい」という初心者の方にも分かりやすく連載で解説する。 「gpt-oss」はチャット機能以外にも活用方法がたくさん? 最新のWeb情報を利用するやり方も伝授

「gpt-oss」はチャット機能以外にも活用方法がたくさん? 最新のWeb情報を利用するやり方も伝授

本連載ではローカルLLMの導入方法から活用方法に至るまで、「手元にハイエンドPCがあって、生成AIをローカル環境で動かしてみたい」という初心者の方にも分かりやすく連載で解説する。 手元にあるゲーミングPCを活用して生成AIを動かす! 無料で使える「LM Studio」のキホンを解説

手元にあるゲーミングPCを活用して生成AIを動かす! 無料で使える「LM Studio」のキホンを解説

本連載ではローカルLLMの導入方法から活用方法に至るまで、「手元にハイエンドPCがあって、生成AIをローカル環境で動かしてみたい」という初心者の方にも分かりやすく連載で解説する。 手元にゲーミングPCがあれば、オフライン環境でも生成AIが利用できるってホント? ローカルLLM(大規模言語モデル)導入を解説

手元にゲーミングPCがあれば、オフライン環境でも生成AIが利用できるってホント? ローカルLLM(大規模言語モデル)導入を解説

本連載ではローカルLLMの導入方法から活用方法に至るまで、「手元にハイエンドPCがあって、生成AIをローカル環境で動かしてみたい」という初心者の方にも分かりやすく連載で解説する。 米AMD、RyzenやRadeonで生成AIをローカル実行するハウツーガイドを公開

米AMD、RyzenやRadeonで生成AIをローカル実行するハウツーガイドを公開

GPTベースのLLM(大規模言語モデル)を使ったAIチャットbotの実行、LLMをローカルでカスタマイズできる検索拡張生成(RAG)の導入、プログラミングにおけるコーディングアシスタントの実行という3つの手順を紹介している。 NVIDIAがPC上のデータを使うAIチャットbotツール「Chat with RTX」公開/AMD製CPUに複数の脆弱性

NVIDIAがPC上のデータを使うAIチャットbotツール「Chat with RTX」公開/AMD製CPUに複数の脆弱性

うっかり見逃していたけれど、ちょっと気になる――そんなニュースを週末に“一気読み”する連載。今回は、2月11日週を中心に公開された主なニュースを一気にチェックしましょう!

Copyright © ITmedia, Inc. All Rights Reserved.

アクセストップ10

- 6500円でデスクに新風! Thermalrightの小型液晶がヒット、背景にメモリ高騰? (2026年02月09日)

- 手のひらサイズの小型PCがお得に! GEEKOMが「冬セール」を開催中 (2026年02月12日)

- ワコムが安い? 驚きの2025年を振り返り メモリ高騰におびえる2026年の「自作PC冬眠」と「次世代CPU」への期待 (2026年02月12日)

- カラー電子ペーパーで好きな画像を飾れる「SwitchBot AIアートキャンバス」が楽しい 13.3型の迫力と魅力 (2026年02月13日)

- キンタロー。も驚くほぼ「入力ゼロ」の“次世代”確定申告 2026年の弥生は3つのAI活用とデスクトップ製品強化を両輪に (2026年02月12日)

- PC値上げの波はVAIOにも? 糸岡社長が明かす「マウスエフェクト」への対応とブランド価値の向上 (2026年02月13日)

- 新ARグラス「XREAL 1S」を試す 解像度と輝度が向上、BOSEサウンドで没入感アップ “3D変換”も大きな魅力 (2026年02月10日)

- アイ・オー、拡張ドック機能を備えたType-C接続対応の27型4K液晶ディスプレイ (2026年02月12日)

- 元Appleのジョナサン・アイブが手掛けるフェラーリ初EVの内装デザイン公開 物理ボタンとデジタルの融合 (2026年02月10日)

- 「雲」から降りてきたAIは「パーソナル」な存在になれるのか――開催から1カ月経過した「CES 2026」を振り返る (2026年02月12日)