最大50TOPSのCopilot+ PC認定ミニPC「Minisforum AI X1 Pro」を試す 推論性能やモンハンベンチで実力検証(4/4 ページ)

生成AI機能を使うからといって、必ずNPUが利用されるわけではない

深い推論が必要なプロンプトを実行する前に、ローカルPCにおけるNPUの利用方法について軽く触れておきたい。

NPUが搭載されていると「生成AI機能がさらに効率的に利用できるようになる」というイメージから「生成AIに関する処理を全てNPUで実行する」と思われる方もいるかもしれないが、これは誤りだ。

現状、ローカルPCにおけるNPUの利用は、生成AIモデルを使って推論する、つまり何らかの論理的な規則に基づいて、既知の事柄から未知の事柄を予想、推理する時にのみに限られる。

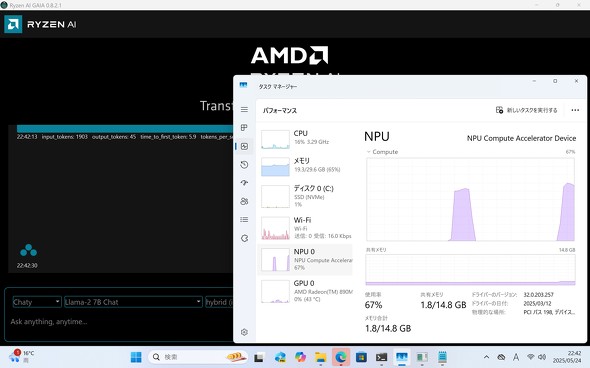

よってプロンプトを実行した際に生成AIモデルが回答を思考する際にNPUが利用され、その後はプロセッサやGPUで演算処理を行うため、NPUの使用率がずっと高止まりするということはない。

これを踏まえた上で、Llama-2 7B ChatをAI X1 Proと参考までに筆者のメインPC(LMStudio)で動かした上で、下記のプロンプトを実施し、1秒あたりに出力されるトークン数を比較してみた。

1秒あたりに出力されるトークン数が多い方はパフォーマンスが高い、と判断してもらえれば幸いだ。なお出力される結果はどちらも日本語ではなく英語で出力されている。

参考用に用意したメインPCの構成は下記の通りだ。

- CPU:Ryzen 7 9700X

- メモリ:DDR5-3600 32GB×4

- GPU:Radeon RX 7700 XT

プロンプトA

あなたは架空の国の首相です。経済成長率が2%で停滞し、失業率が5%に上昇し

ています。財政赤字も拡大傾向です。経済成長を加速し、失業率を下げ、財政健全化を同時に達成するための政策パッケージを3つ提案し、それぞれの政策がどのように相互作用するか、メリット/デメリットも含めて説明してください。

プロンプトB

ある都市で新型の感染症が流行し始めています。感染症の基本再生産数(R0)は2.5で、人口は100万人、初期感染者は100人です。ワクチンの接種率が50%の場合、感染拡大を抑えるためには追加でどれだけの人がワクチンを接種する必要がありますか?また、感染拡大を防ぐための他の公衆衛生対策を3つ挙げ、それぞれの効果と課題を論理的に説明してください。

プロンプトA実行結果

- AI X1 Pro:毎秒14.1トークン

- 筆者メインPC:毎秒8.38トークン

プロンプトB実行結果

- AI X1 Pro:毎秒15.5トークン

- 筆者メインPC:毎秒7.42トークン

結果として、AI X1 Proの方がはるかに1秒あたりに出力されるトークン数が大きいことが分かった。もちろん、生成AIモデルを動かしているアプリがそれぞれ別であることや、グラフィックスメモリの割り当て方法がそもそも違うなど、正確な差を判断する上ではあまり適した比較方法ではない。それにしてもAI X1 Proの結果出力の早さには目を見張る物があった。

GAIAを使っている間、特に廃熱の温度が高くなることもなかったことを考えると、大きなデスクトップPCを用意しなくとも、AI X1 Proを用意するだけで快適に利用できる点は非常に大きなメリット言えよう。

ただ、現状はLMStudioがRyzen AIのNPUに対応していないため、Windowsユーザーが気軽に手元でNPUをフル活用して生成AI機能を利用することはまだ難しいが、昨今の時流やCopilot+ PCの機能拡充など大いに期待できるので、エンスージアスト向けの製品としてAI X1 Proは非常に心躍る製品だと感じた。

新しいもの好きや、生成AIアプリを開発しようと考えているならAI X1検討の価値があるだろう。

関連記事

Ryzen 7 260&Radeon 780M搭載、OcuLinkなど拡張性も充実したミニPC「Minisforum AI X1」を試す

Ryzen 7 260&Radeon 780M搭載、OcuLinkなど拡張性も充実したミニPC「Minisforum AI X1」を試す

今回はRadeon 780Mの性能や、内蔵されたNPUをどう活用できるのか、実機を用いて詳しくチェックしてみた。 「AI X1 Pro」と「MS-A2」推しのMINISFORUMブースでは、AI NASキット「N5 PRO」が分解されていた

「AI X1 Pro」と「MS-A2」推しのMINISFORUMブースでは、AI NASキット「N5 PRO」が分解されていた

ミニPCやゲーミングPCだけでなくNASも手掛けるMinisforumのブースでは、新モデルの多くが分解できる状態で展示されていた。 ミニPCに外付けGPUを接続できる! 約1.2万円のOCuLink拡張ドック「DEG1」、MINISFORUM AI X1で試した

ミニPCに外付けGPUを接続できる! 約1.2万円のOCuLink拡張ドック「DEG1」、MINISFORUM AI X1で試した

ミニPCの弱点だったグラフィックス性能を、約1.2万円のOCuLink拡張ドック「DEG1」で解消できるか? 最新の「MINISFORUM AI X1」で試してみた。 自宅サーバマシンとして「Minisforum MS-01」を2台導入してみた 拡張性と接続性が魅力、Intel AMTの設定も解説

自宅サーバマシンとして「Minisforum MS-01」を2台導入してみた 拡張性と接続性が魅力、Intel AMTの設定も解説

Minisforum MS-01のCore i9-13900HとCore i9-12900Hを搭載した2モデルをサーバマシンとして購入してみたので、実機をもとにMS-01の魅力と、UEFI画面から遠隔操作できる「Intel AMT」について詳しく紹介していこう。 Core i9搭載のミニPC「Minisforum NAB9」は最大4画面出力に対応 ワンタッチでカバーも取れる その実力をチェックした

Core i9搭載のミニPC「Minisforum NAB9」は最大4画面出力に対応 ワンタッチでカバーも取れる その実力をチェックした

Intel Core i9-12900HKを搭載しながら8万円弱から購入できる「Minisforum NAB9」をレビューする。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

アクセストップ10

- メモリの価格上昇が一段落、枯渇していた「RTX 5090」も再入荷 止まらぬパーツ高騰の合間に訪れた一時の平穏 (2026年02月14日)

- 珍しい縦折り&日本語配列の「Ewin 折りたたみ式ワイヤレスキーボード」がセールで25%オフの3980円に (2026年02月13日)

- カラー電子ペーパーで好きな画像を飾れる「SwitchBot AIアートキャンバス」が楽しい 13.3型の迫力と魅力 (2026年02月13日)

- デスクトップの音響環境を改善する「Edifier M60」が21%オフの1万8979円に (2026年02月13日)

- 6500円でデスクに新風! Thermalrightの小型液晶がヒット、背景にメモリ高騰? (2026年02月09日)

- 手のひらサイズの小型PCがお得に! GEEKOMが「冬セール」を開催中 (2026年02月12日)

- エイサー、Ryzen AIを採用した薄型軽量16型ノート「Swift Air 16」 (2026年02月13日)

- Windows 11 26H1は「Qualcomm Snapdragon X2」専用に/「東京ゲームショウ2026」は初の5日間開催 (2026年02月15日)

- ソニーが「Blu-ray Discレコーダー」の出荷と開発を終了 代替の録画手段はある? (2026年02月09日)

- VAIOのキッティングと修理は“ふるさと”で――担当者が語るメリットとは? (2026年02月13日)