KDDIの通信障害で考えるべき「3つの課題」 障害を起こさないため/起きたときにどうすべきか(1/2 ページ)

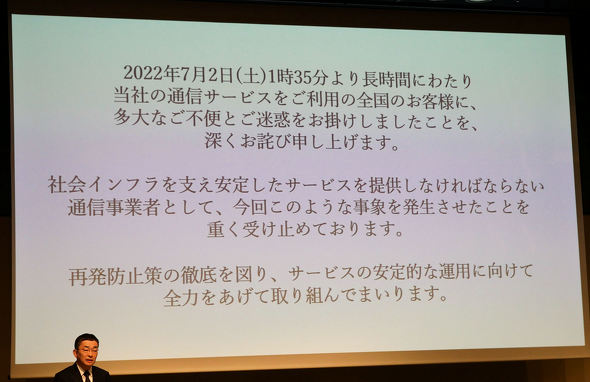

KDDIが7月29日に記者会見を開き、7月2日から4日にかけて発生した通信障害の原因と再発防止策について説明した。

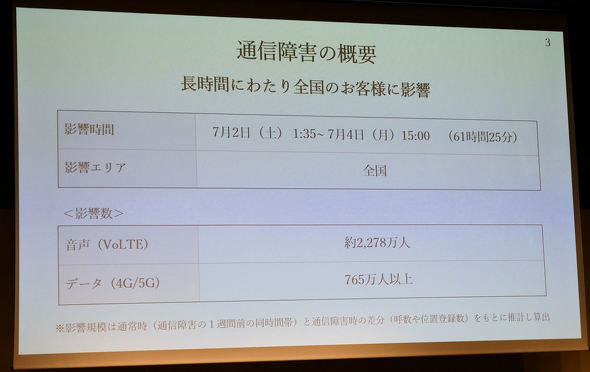

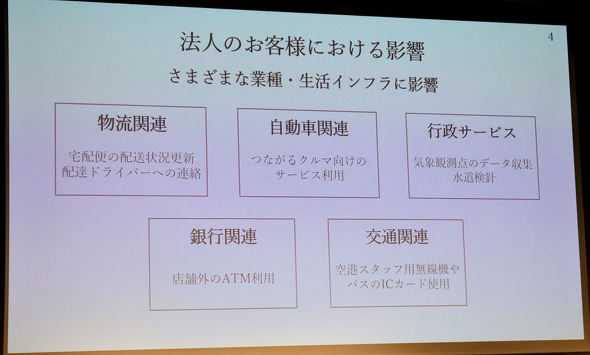

今回の通信障害は、7月2日1時35分から4日15時まで、61時間25分にわたって全国で発生するという大規模なものになった(復旧の最終確認をしたのは、障害発生から86時間1分後の5日15時36分)。携帯事業者が起こした通信障害としては過去最大といえ、ユーザーの日常生活や産業に多大な影響を及ぼした。本稿では、29日の説明をもとに、「障害の原因と再発防止策」「障害発生後の告知方法」「障害が起きた際の対応策」について解説する。

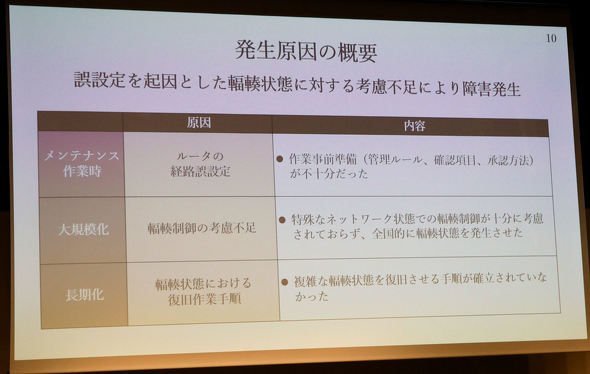

障害の原因は「人為ミス」と「復旧手順の確認不足」

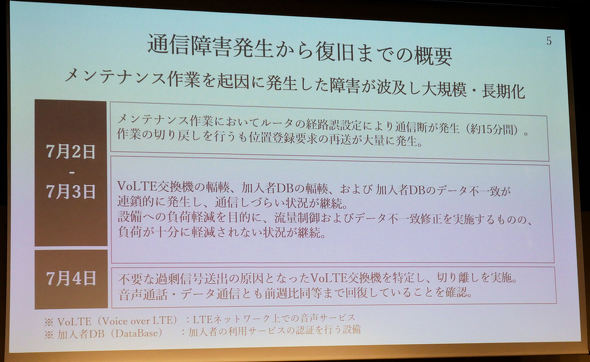

まずは障害の原因について。7月2日、多摩ネットワークセンターに設置した全国中継網ルーターのメンテナンス作業中に、ルーターの経路を誤設定してしまった。そもそもなぜ誤設定してしまったのか。取締役執行役員専務の吉村和幸氏によると、「ネットワークのルーティングのポリシーに変更があり、手順書の変更が発生したので、新しい手順書を使わないといけなかったが、古い手順書を使ってしまった」ことが原因だという。手順書の承認作業は経ていたが、目視で確認していたため、ミスに気付かなかったようだ。吉村氏は「目検だけでなくシステム的なところで確認できるよう取り組んでいく」と話す。

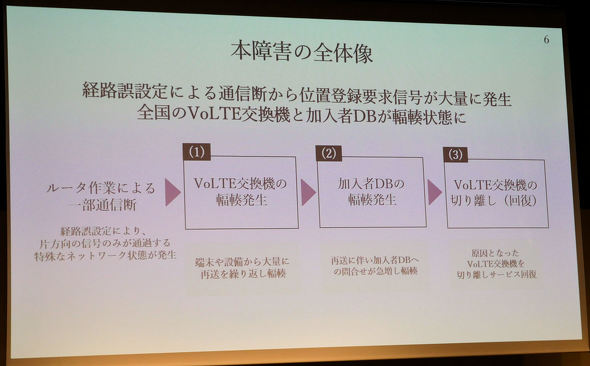

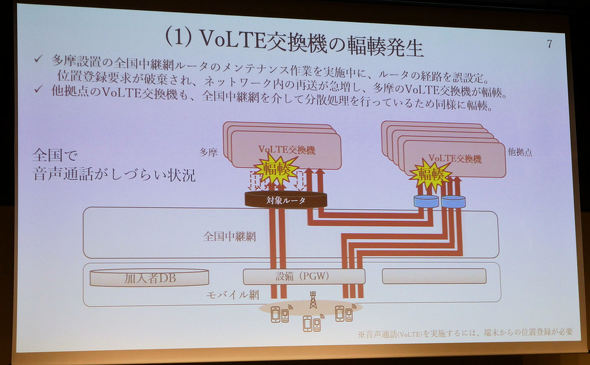

ルーター経路の誤設定によって位置登録要求が破棄され、ネットワーク内の再送が急増して、多摩ネットワークセンターのVoLTE交換機にトラフィックが集中する輻輳(ふくそう)が起きた。全国中継網を介して分散処理を行っているため、他の拠点にあるVoLTE交換機も同様に輻輳となった。これにより、全国で音声通話がしづらい状況に陥った。

この誤設定を素早く修復できていれば、ここまで大規模化することはなかった。大規模化した要因について高橋誠社長は「特殊なネットワーク状態での輻輳制御が十分に考慮されていなかった」ことを挙げる。

障害発生後、すぐに多摩ネットワークセンターを訪れて話を聞いたという高橋氏は「ルートの誤設定をした後に、1分くらいでVoLTE交換機が輻輳していたが、設定を戻すまでに15分ほどの時間が掛かってしまった。VoLTE交換機をリセットしながら直すのだが、バックアップファイルが壊れて生成されていた」と振り返る。バックアップファイルは定期的に生成されるが、その際に輻輳が起きて異常な状態となったことで壊れてしまい、この発見に時間が掛かってしまったことが長期化につながった。

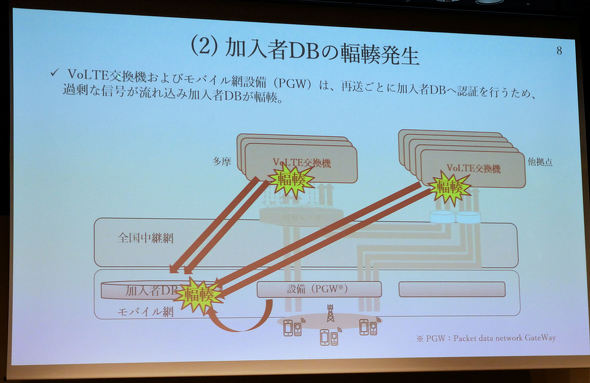

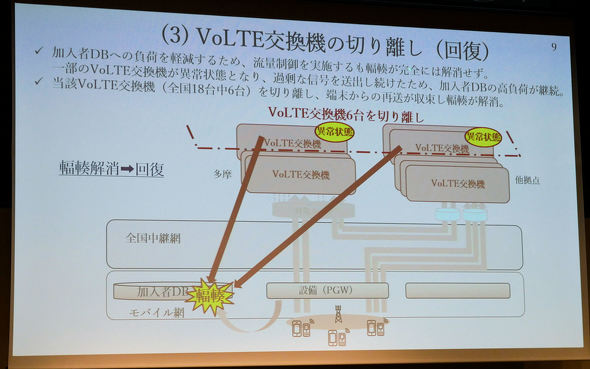

VoLTE交換機と、モバイル網の設備であるPGW(Packet data network GateWay)は、ネットワーク内で再送するごとに加入者データベースに認証を行うが、その際に過剰な信号が流れ込んで、加入者データベースも輻輳を起こした。加入者データベースの負荷を抑えるために流量制限を実施したものの、輻輳は解消しなかった。そんな中、VoLTE交換機18台のうち、6台が過剰な信号を送出していたことが分かった。そこで、これら6台を切り離すことで再送が収まって輻輳が回復した。

こうした輻輳の流れはKDDIも想定外だった。先述のバックアップファイルの破損やVoLTE交換機6台の異常を把握するのに時間が掛かったことを含め、「複雑な輻輳状況における復旧手順が確立されていなかった」ことが長期化につながった。

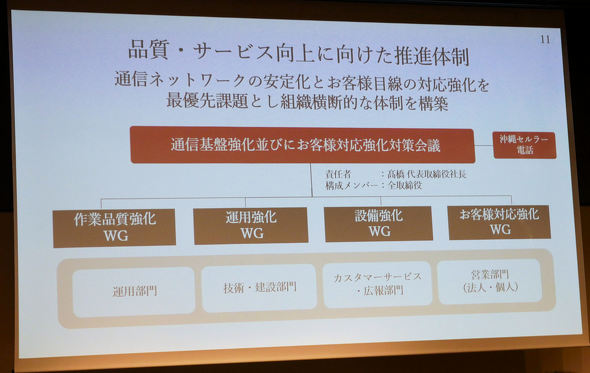

今回の障害を受け、KDDIは品質とサービスの向上に向けた体制を作っていく。高橋氏を責任者とする対策会議を開き、「作業品質強化」「運用強化」「設備強化」「お客さま対応強化」のワーキンググループを作る。

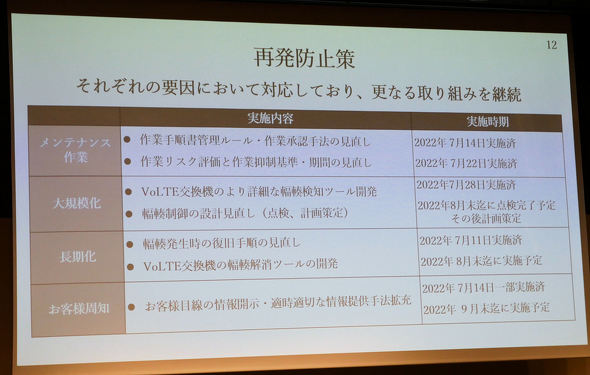

障害の課題を「メンテナンス作業」「大規模化」「長期化」「ユーザー周知」の4点に分類して再発防止策を策定。メンテナンス作業では、作業手順管理ルールや作業承認手法、作業リスク評価や作業抑制基準などを見直す。大規模化については、VoLTE交換機のより詳細な輻輳検知ツールを開発し、輻輳制御の設定を見直す。

ユーザー周知について、詳細は後述するが、ユーザー目線の情報開示と、適切なタイミングでの情報提供手法を2022年9月末までに拡充していくとしている。

関連記事

KDDI通信障害、「約款返金271万人」と「おわび返金200円」の根拠は?

KDDI通信障害、「約款返金271万人」と「おわび返金200円」の根拠は?

KDDIが、7月2日から4日にかけて発生した通信障害に関するユーザーへの返金を発表した。約款返金として、24時間以上通信サービスを利用できなかったユーザーに、基本料金の2日相当分を返金する。その他、影響の大きさを鑑みて、3589万人に200円のおわび返金を行う。この「271万人」と「200円」の根拠はどこにあるのか。 通信障害の再発防止には限界も 緊急時の「ローミング」と「SIMなし発信」は実現するか

通信障害の再発防止には限界も 緊急時の「ローミング」と「SIMなし発信」は実現するか

通信障害の原因究明と再発防止に乗り出しているKDDIだが、こうした事故は100%防げるとは限らない。規模の大小や時間の長短を問わなければ、1年に数回は起こること。その考え方を前提にしつつ、業界全体で影響を最小限に抑える取り組みをしていく必要がある。 au/UQ mobile/povo携帯電話の通信障害は解消 焦点は「再発防止策」と「情報周知」に

au/UQ mobile/povo携帯電話の通信障害は解消 焦点は「再発防止策」と「情報周知」に

KDDIと沖縄セルラー電話における携帯電話ネットワークの通信障害がようやく解消した。それに合わせてKDDIが再度記者説明会を開催し、今後の方針を説明した。 KDDIの通信障害が完全復旧 5日15時36分に最終確認

KDDIの通信障害が完全復旧 5日15時36分に最終確認

KDDIは、7月2日1時35分から発生していた通信障害が復旧したことを発表した。個人と法人のサービス利用に問題がないことを、5日15時36分に最終確認した。音声通話やデータ通信が利用しにくい場合、端末の電源オン/オフの操作を試すよう呼びかけている。 KDDIの通信障害なぜ長期化した? 過去の障害で得た知見も通用せず

KDDIの通信障害なぜ長期化した? 過去の障害で得た知見も通用せず

KDDIが7月4日20時に、2日から発生している通信障害について、現状と復旧の見通しを説明した。通信障害の原因はVoLTE交換機の輻輳(ふくそう)だが、負荷低減を行ったにもかかわらず、音声通話が利用しにくい状況が続いていた。調査をしたところ、KDDIが運用しているVoLTE交換機18台のうち、6台が加入者データベースに不要な過剰信号を送信していることが判明した。

Copyright © ITmedia, Inc. All Rights Reserved.

アクセストップ10

- 「iPhone 17e」と「iPhone 17」は何が違う? 3万円の価格差をスペックから検証する (2026年03月10日)

- 庵野秀明、GACKT、ひろゆき、ドワンゴ川上らが集結 “カメラのいらないテレビ電話”をうたう新サービス「POPOPO」18日に発表へ (2026年03月11日)

- 「iPad Air(M4)」実機レビュー 「もうProじゃなくてもいい」と思えた性能、だからこそ欲しかったFace ID (2026年03月09日)

- 「iPhone 17e」を試して分かった“16eからの進化” ストレージ倍増と実質値下げで「10万円以下の決定版」に (2026年03月09日)

- どこでもウユニ塩湖? 3COINSで550円の「スマホ用反射ミラークリップ」を試す (2026年03月12日)

- 自分で修理できるスマホ「Fairphone(6th Gen.)」を見てきた わずか10分で画面交換、2033年まで長期サポート (2026年03月10日)

- 携帯キャリアの通信9サービス、総合満足度はpovoがトップ サブブランド勢が好調 MMDが調査 (2026年03月10日)

- キーボード付きスマホ「Titan 2 Elite」がUnihertzから登場 実機に触れて分かった“絶妙なサイズ感” (2026年03月09日)

- 60ms未満の音声遅延速度で端末をワイヤレス化「UGREEN USBオーディオトランスミッター」が30%オフの2309円に (2026年03月09日)

- 「Galaxy S26」シリーズはどこが安い? 一括価格と2年間の実質負担額を比較、お得なキャリアはココだ (2026年03月11日)