Googleが「ググる常識」を捨て、検索に「AIモード」を追加 何がどう便利に?

米Googleは5月20日(現地時間)、年次開発者会議「Google I/O 2025」で、Google検索に「AIモード」を追加すると発表した。

従来の検索と異なり、より高度な推論やマルチモーダル処理、追加の質問やWebへのリンクを通じてより深く掘り下げる能力を持つ。Googleは「最も強力なAI検索」とアピールする。

Googleは、AIモードで利用できるようになる一連の新機能群も明らかにした。

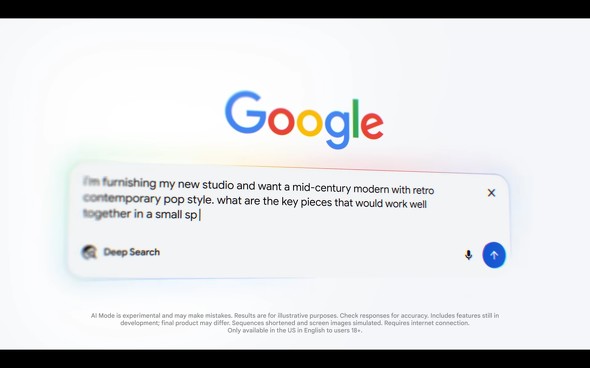

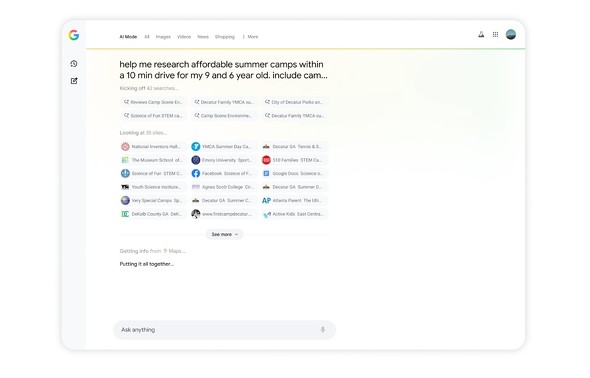

徹底的に調査を行い、レポートを作成する「Deep Search」

例えば、「Deep Search」という機能では、より深く詳細な回答が求められる質問に対して、徹底的に調査を行える。数百もの検索を同時に実行し、散在する多様な情報を横断的に分析。専門家レベルのリサーチを行うだけでなく、レポートを“わずか数分”で作成する。

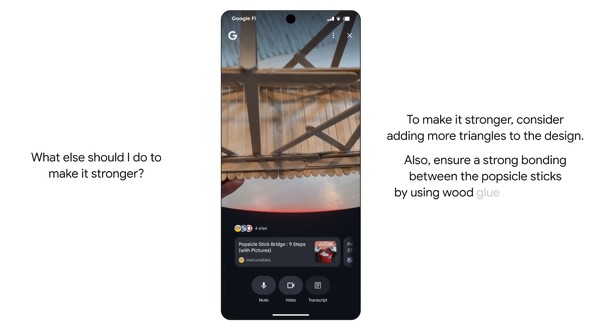

Google 検索で視覚検索が可能に ユーザーが見ている景色を理解

次のトピックは、次世代かつマルチモーダルAIアシスタントである「Project Astra(アストラ)」による視覚検索だ。

文字通り、Google 検索は“ユーザーが見ている景色を理解できる”学習パートナーとなり、難しい概念を説明したり、Webサイト、動画、掲示板などのさまざまな情報元へのリンクとともにアドバイスを行う。スマートフォンのカメラを使って周囲の物について会話をしながら検索することも可能だ。

チケット予約や価格比較を代行 日々のタスクにかかる時間を節約

Google 検索を利用すれば、日々のタスクにかかる時間を節約できるようにもなる。Chromeブラウザ向けのAIエージェント「Project Mariner(マリナー)」は、チケットの予約や価格の比較といった作業を代行。これも検索を“行動”の支援へと拡張するアプローチだ。

自分にとって最適な商品を見つけるのはAIに

近い将来、自分にとって最適な商品を見つけるのは、人ではなくAIになるだろう。

AIモードには、「ショッピング支援」機能もあり、Gemini モデルの能力と Google のショッピンググラフを組み合わせ、インスピレーションを得るための商品探索、購入前の熟考、商品の絞り込みまであらゆる段階でユーザーをサポートする。

例えば、コーディネートがどのように見えるかを確認したい場合は、自分の写真を1枚アップロードするだけで、何十億点ものアパレル商品を仮想的に試着できる。適切な価格でぴったりなアイテムが見つかったら、ユーザーは新しい「エージェント型チェックアウト」機能にGoogle Payでの購入を依頼できる。

過去の検索履歴などにもとづいて最適な提案を行う機能なども

個人の過去の検索履歴やGmailなどと連携し、パーソナルな文脈を活用して、AIモードでユーザーに最適な結果を提案する機能や、スポーツや金融のデータをもとにカスタムチャートを自動で作成する機能もある。

従来のキーワード主導の検索である「ググる常識」から脱却

Google 検索といえば、キーワード入力や音声での検索を想起しやすかったが、対話的かつ文脈的にユーザーの意図を理解し、能動的に調査や提案などを実行できるAIモードにより、Google 検索での体験は大きく変わるだろう。

それどころか、従来のキーワード主導の検索である「ググる常識」から脱却し、単なる情報取得の手段となっていたGoogle 検索そのものが“ユーザーにとって知的なAIパートナー”にもなり得る。

Googleは5月20日から、AIモードを米国の全ての人に提供する。あわせて、I/Oで紹介したすべての新機能については、今後数週間から数カ月の間に、試験的な新機能や技術を試せるユーザーに提供する。

(※)記事内で引用しているGoogle Japan Blogの画像は、実際の画面とは異なる場合がある。ユーザーが実際に利用する際の表示内容などは、掲載イメージと異なる可能性がある

関連記事

Gemini Liveの「カメラと画面共有」機能、全てのAndroidとiOS向けに無料提供

Gemini Liveの「カメラと画面共有」機能、全てのAndroidとiOS向けに無料提供

Googleが5月21日、生成AIを使った画面共有機能「Gemini Live」を、AndroidとiOSに無料で提供することを発表した。Gemini Liveは、テキスト入力せず音声でAIと会話をしたり、スマートフォンのカメラで映したものを相談したりできる機能。 Pixelシリーズに「Gemini Live」でカメラに写ったものについて会話できる新機能追加

Pixelシリーズに「Gemini Live」でカメラに写ったものについて会話できる新機能追加

Googleは、Androidスマートフォン向けに、「Gemini Live」に端末のカメラを通して見ているものを認識させ、それについて会話できる新機能を発表した。まずは「Pixel 9」シリーズと「Galaxy S25」で利用可能になる。 音声でAIと会話する「Gemini Live」が日本語に対応 40言語に拡大

音声でAIと会話する「Gemini Live」が日本語に対応 40言語に拡大

Googleは、パーソナルAIアシスタント「Gemini」と音声で会話することができる「Gemini Live」の対応言語を40以上に拡大。日本語を含むさまざまな言語で会話が可能となり、同じデバイスで最大2言語での会話をサポートする。 iOS版「Geminiアプリ」リリース iPhoneでも日本語での音声会話が可能に

iOS版「Geminiアプリ」リリース iPhoneでも日本語での音声会話が可能に

Googleは、AIアシスタント「Geminiアプリ」のiOS版をリリースした。Android版と同様、日本語音声で会話できる。iOS 16以降を搭載したiPhoneとiPadで利用可能だ。 さよなら「Googleアシスタント」──Pixel 9では「Gemini」がデフォルトに

さよなら「Googleアシスタント」──Pixel 9では「Gemini」がデフォルトに

Googleは、「Pixel 9」シリーズではデフォルトのアシスタントを「Gemini」にすると発表した。電源ボタンの長押しや「OK Google」で起動するのは「Googleアシスタント」ではなくGeminiになる。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

アクセストップ10

- 「iPhoneのシェアの高いスマホ市場」に異変!? ショップ店員に聞く「Androidスマホ人気」の実情 (2026年02月27日)

- 3キャリアに聞く「Galaxy S26」戦略 「月1円」のソフトバンク、3年ぶり参戦の楽天、16周年のドコモ (2026年02月27日)

- 楽天モバイル回線のMVNOサービス「ゼロネオモバイル」登場 月額6248円でデータ無制限、60回払いで端末実質0円 (2026年02月25日)

- 5G通信とMagSafeをサポート! 片手でも持ちやすい「iPhone 12 mini(128GB)」のAmazon整備品が約3万円から (2026年02月26日)

- 「Galaxy S26/S26+」発表、日本では5年ぶり「+」モデルも 新チップ搭載でカメラやAIの処理性能が向上 (2026年02月26日)

- 「d払い」アプリ、データ読み込み中に支払いコードを表示可能に (2026年02月26日)

- ポケモンとYahoo! JAPANが30周年コラボ LINEも特別デザインに 検索画面に“赤・緑の3匹”が登場する演出も (2026年02月27日)

- 最上位モデル「Galaxy S26 Ultra」発表 のぞき見防止ディスプレイや明るいカメラ搭載 実機を写真で解説 (2026年02月26日)

- 「eSIM」は人類にとって早すぎる? 携帯電話ショップ店員に聞いたら意外な答えが (2025年11月28日)

- 前モデルからバッテリー持ちやカメラが進化! Amazon整備済み「iPhone 13(128GB)」が約5万円から (2026年02月26日)