Intel“逆襲”の鍵はやはり「AIプロセッサ」か 次世代CPU「Core Ultra(Meteor Lake)」を解説(後編)(1/4 ページ)

Intelは9月19日(米国太平洋夏時間)、モバイル向け次世代CPU「Core Ultraプロセッサ」(開発コード名:Meteor Lake)のアーキテクチャの詳細を発表した。

発表に先駆けて技術説明会に参加した筆者は、その詳細を2つの記事に分けて紹介することにした。前編は、読者からの関心が特に高いであろう、CPUコアにまつわる特徴を中心に解説している。

前編で取り上げたことを軽くおさらいすると、以下の通りとなる。

- Meteor Lakeは「タイルアーキテクチャ」という、Intel独自のチップレット技術を採用

- タイル(チップレット)は「Compute」「Graphics」「I/O」「SoC」の4つ

- Compute Tileは、基本的に第12/第13世代CoreプロセッサのPコア/Eコアの改良版

- SoC Tileにも、追加で消費電力をより削減したCPUコア「LP Eコア」を搭載

- PコアとEコアに処理を割り振る「Intel Thread Director」に改良を実施

今回は、SoC Tileに搭載されるLP Eコア以外の機能と、Graphic TileやI/O Tileの詳細をひもとく。

【訂正:9月24日8時20分】NPUのスペック表記の一部に誤りがありました。おわびして訂正いたします。

全モデルに搭載される「NPU」

SoC Tileには、LP Eコアと並んで注目すべき機能として「NPU(Neural-network Processing Unit:AIプロセッサ)」が搭載されている。NPUはAI(人工知能)に欠かせない「推論処理」を高速化する演算ユニットで、「推論プロセッサ(アクセラレーター)」とも呼ばれる。

NPUは従来、GPUやスマートフォン向けSoCに搭載されることが多かった。GeForce RTXシリーズなど、NVIDIAのGPUに搭載されている「Tensorコア」や、AppleのMac/iPhone/iPad向けSoCに搭載される「Neural Engine」などは、広く認知されているだろう。

神経回路を意味する「Neural(ニューラル)」を冠することから、えらく高度なことをやっているようなイメージもあるNPUだが、実際にやっていることはただの行列演算である。

Meteor Lakeに搭載されたNPUは、Intelに買収されたMovidius(モビディウス)という企業が開発していた「VPU(Vision Processing Unit)」の思想を色濃く反映している。

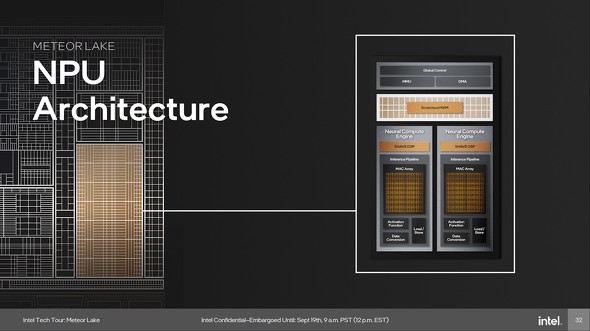

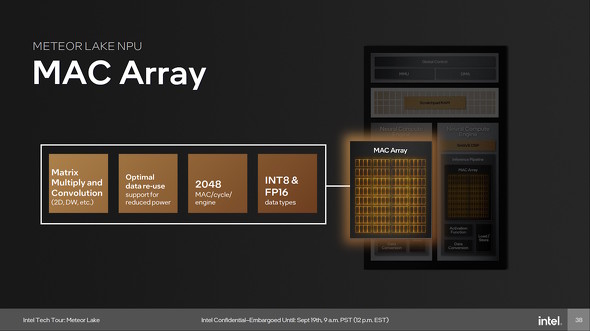

Meteor Lakeでは、1基のNPUに2基の「NCE(Neural Compute Engine:ニューラル演算エンジン)」が搭載されている。NCEの1基当たりの演算能力は、FP16(16bit浮動小数点演算)で1クロックあたり1024回、INT8(8bit整数演算)で1クロックあたり2048回だ。

ブロック図をジッと見つめると、1基のNCEは4SIMD演算器を32基搭載しているように見える。Intel Arc Graphicsシリーズ(GPU)における「XMX(Xe Matrix Engine)」と構成が似ている

ブロック図をジッと見つめると、1基のNCEは4SIMD演算器を32基搭載しているように見える。Intel Arc Graphicsシリーズ(GPU)における「XMX(Xe Matrix Engine)」と構成が似ているMeteor LakeのNPUには、推論プロセッサの他、128bitの「SIMD-VLIWプロセッサ」も搭載されている。このプロセッサはいわゆる「DSP(Digital Signal Processor)」なのだが、Intelによると、これはMovidiusが開発した「SHAVE(Streaming Hybrid Architecture Vector Engine)」を“そのまま”載せたものだという。

一般的に、DSPは入力されたデータストリームの1つ1つに対して、短いプログラムを適用して演算を進めるイメージがある。それに対して、SHAVEはPlayStation 3のメインプロセッサとして知られる「Cell Broadband Engine」に内包されていた「SPU(Synergistic Processing Unit)」に似た実装となっている。

具体的には、メインCPUを介さずにメインメモリからデータを入出力できる「DMA(Direct Memory Access)」に対応している他、スクラッチパッドメモリをローカルメモリ空間として活用し、超高速なデータ加工を行えるようになっているからだ。

ブロック図を見ると、SHAVEが占める面積は小さい。しかし、ほぼCPU的に複雑なデータ処理を行える。具体的には、128bitベクトル演算器、32bit整数演算器、32bit整数8要素SIMDスカラ演算器、比較命令、分岐予測、ループ制御など、高度なプログラミングが可能な各種演算器を搭載している。依存関係がなければ、1クロックあたり最大で8つの命令を実行できるという。

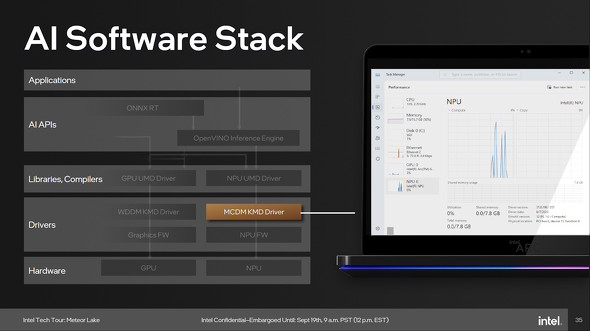

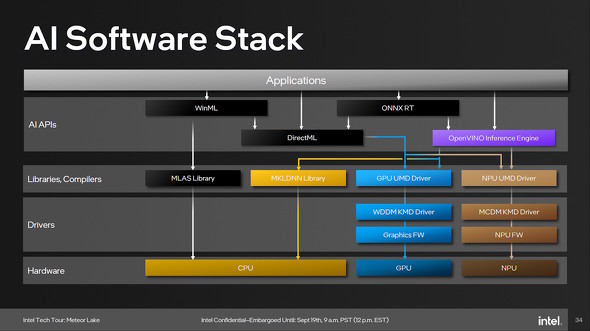

さて、気になる「NPUの活用方法(≒プログラミングモデル)」だが、新命令セットを用いるのではなく、Intelが開発した深層学習型AIの開発フレームワーク「OpenVINO」のAPIを介して利用する形態を取る。Microsoftと連携して開発してきた、WindowsからNPUを利用するためのサブシステム「MCDM(Microsoft Compute Driver Model)」にも対応する予定となっている。

そのため、AIを利活用するWindowsアプリがOpenVINOまたは「DirectML」をベースに構築されている場合、PCにMeteor LakeのNPU/GPU用のMCDMドライバーがインストールされていれば、NPU/GPUによるAIアクセラレーションが有効となる。

ちなみに、MCDMドライバーの実体構造は「3Dグラフィックス関連の機能を省いたGPUドライバー(≒WDDMドライバー)そのものに相当」するそうだ。

なお、NPUが搭載されておらず、かつMCDMドライバーのないGPUを使っている環境でも、OpenVINOから「MKL-DNN(Intel Math Kernel Library for Deep Neural Networks)」にアクセスできれば、CPUコアを用いた代替演算で当該アプリを稼働できる。

Meteor LakeにおいてAI処理を行う際のソフトウェアスタックの図。NPUを利用する場合は、OpenVINOあるいはDirectMLを用いることになる(DirectML経由でWinMLやONNX RTからもアクセス可能)

Meteor LakeにおいてAI処理を行う際のソフトウェアスタックの図。NPUを利用する場合は、OpenVINOあるいはDirectMLを用いることになる(DirectML経由でWinMLやONNX RTからもアクセス可能)Intelでは、今後リリースされるCoreプロセッサの多くにNPUを搭載する予定だという。とりわけ、Meteor Lakeでは全製品(SKU)にNPUを搭載するとしていて、「AIアプリの実行」という観点から、Intelプラットフォームの“巻き返し”を図る方針だ。

関連記事

「Meteor Lake」はCPUコアが3種類!? Intelが次世代CPUの詳細を発表(前編)

「Meteor Lake」はCPUコアが3種類!? Intelが次世代CPUの詳細を発表(前編)

Intelが、次世代CPUとして2023年末に正式発表する予定の「Meteor Lake」のアーキテクチャ面での詳細を発表した。この記事では、CPUコアを備える「Compute Tile」と、高度な機能を複数搭載する「SoC Tile」にある“謎の新要素”について詳説する。 Intelが「第5世代Xeonスケーラブルプロセッサ(Emerald Rapids)」を12月14日に発表 先の新製品のスケジュールも順調

Intelが「第5世代Xeonスケーラブルプロセッサ(Emerald Rapids)」を12月14日に発表 先の新製品のスケジュールも順調

Intelが2023年後半に発売するしていた「第5世代Xeonスケーラブルプロセッサ」を12月14日(米国太平洋時間)に正式発表することを明らかにした。現行の第4世代製品を改良してより処理効率を高めたもので、CPUソケットの互換性もある。 モバイル向けGPU「Intel Arc Aシリーズ」が発進 スペック別に3シリーズを順次投入

モバイル向けGPU「Intel Arc Aシリーズ」が発進 スペック別に3シリーズを順次投入

Intelが、モバイル向けGPU「Intel Arc Aシリーズ」を正式に発表した。米国ではエントリー製品を搭載するノートPCの受注が始まっており、4月から搭載製品が順次お披露目される見通しだ。 IntelがゲーミングGPU「Intel Arc」におけるフレームレート改善を報告 計測ツール「PresentMon」のβ版も一般公開

IntelがゲーミングGPU「Intel Arc」におけるフレームレート改善を報告 計測ツール「PresentMon」のβ版も一般公開

Intelが、同社製ゲーミングGPU「Intel Arc Graphics」の近況報告を行った。新しいGPUの予定などは公表されなかったものの、グラフィックスドライバーの継続的更新を実施していることや、今後もゲーミンググラフィックスに対するコミットメントを強化することが表明された。 イスラエルのIntelハイファラボで見た“ちょっと未来”のPC像

イスラエルのIntelハイファラボで見た“ちょっと未来”のPC像

Intelはイスラエルに一大拠点を構えている。先日、報道関係者向けにその現状を伝えるツアーが開催されたが、今回は「Intel 8088」や「MMX Pentium」などを生み出したハイファにあるIDC(Israel Development Center)において実際に研究/開発された技術のデモンストレーションの様子をお伝えする。

Copyright © ITmedia, Inc. All Rights Reserved.

アクセストップ10

- 10万円切りMacが17年ぶりに復活! 実機を試して分かったAppleが仕掛ける「MacBook Neo」の実力 (2026年03月10日)

- きょう発売の「MacBook Neo」、もうAmazonで割安に (2026年03月11日)

- 「MacBook Neo」を試して分かった10万円切りの衝撃! ただの“安いMac”ではなく絶妙な引き算で生まれた1台 (2026年03月10日)

- 新型「MacBook Air」はM5搭載で何が変わった? 同じM5の「14インチMacBook Pro」と比べて分かったこと (2026年03月10日)

- セールで買った日本HPの約990gノートPC「Pavilion Aero 13-bg」が想像以上に良かったので紹介したい (2026年03月11日)

- リュック1つで展示会セミナーの音響セット構築レポ 現場で得た“2.4GHz帯混信地獄”を生き抜く教訓 (2026年03月11日)

- 最新Core Ultra X7 358Hの破壊力! 16型OLED搭載で内蔵GPUがディスクリート超え!? Copilot+ PC「Acer Swift 16 AI」レビュー (2026年03月10日)

- 12機能を凝縮したモニタースタンド型の「Anker 675 USB-C ドッキングステーション」が27%オフの2万3990円に (2026年03月11日)

- 出張や通勤で荷物が増えても安心な「ミレー ビジネスリュック EXP NX 20+」が27%オフの1万3865円に (2026年03月10日)

- 「iPhone 17e」実機レビュー! 9万9800円で256GB&MagSafe対応 ベーシックモデルの魅力と割り切り (2026年03月09日)