プライバシーを守りつつAIの利点を活用――「Google Pixel 3」のオンデバイスAI技術

Googleが11月1日に発売した「Pixel 3」「Pixel 3 XL」。AI(人工知能)を活用したカメラ機能が特徴で、先日のカメラアプリの更新によって「夜景モード」が追加された。

AIといえば、大量のサンプルデータをコンピュータに入力し、それをもとに作成された学習モデルを使ってさまざまな判断をしていく「機械学習」が思い浮かぶ。昨今の機械学習はクラウド(オンラインサーバ)上で処理を行うものが多いが、Pixel 3/Pixel 3 XLではカメラ機能などで「オンデバイスAI」という端末内で処理が完了する機械学習を取り入れているという。

なぜ、GoogleはオンデバイスAIに注力しているのだろうか。同社の特別名誉科学者で、オンデバイスAIの研究・開発を担当するブレイス・アグエラ・イ・アルカス氏が報道関係者向けに解説した。

CPUの多コア化が「ニューラルネットワーク」の進化をもたらす

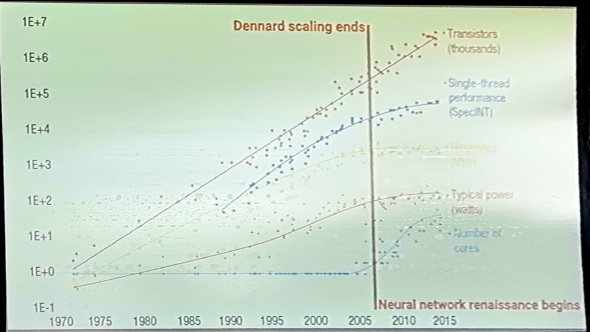

CPUを始めとする半導体の世界には「ムーアの法則」がある。米Intelの創業者の1人であるゴードン・ムーア氏が提唱した、「半導体のトランジスタ数は18カ月(1年半)ごとに倍増する」という旨の法則だ。これに従うかのように、CPUのトランジスタ数はおおむね1年半ごとにトランジスタ数を倍増していった。

しかし、2006年を境にそのトレンドに若干の変化が表れる。CPUの主な性能向上手段が「稼働周波数の向上」から「コアの増量」に移行し、トランジスタの小型化も手伝って処理能力の向上と消費電力の削減が進んだ。

一方で同じ頃、機械学習の分野では脳細胞の構造をモデルとする「ニューラルネットワーク」という処理モデルが大きな前進を見せ始めた。シリアル(単一)な処理を得意としてきたCPUが多コア化することで、ニューラルネットワークの特徴であるパラレル(並列)処理に強くなったからだ。

「偶然なのか歴史の流れなのかという点について議論はある」(アルカス氏)ものの、CPUが多コア化したことがニューラルネットワークの進化を後押ししたことは間違いない。現在ではHuaweiやAppleなどのように、機械学習処理用の処理領域を持つスマートフォン・タブレット用プロセッサの開発を進める企業も増えた。

アルカス氏は「8年後にはプロセッサの(トランジスタ)の99%はニューラルネットワークの処理に使われることになるだろう」と、個人的な見通しを語る。

オンデバイスAIに注力するのは「プライバシーへの配慮」

Googleも、2013年に機械学習に特化した並列処理プロセッサ「TPU(Tensor Processing Unit)」を開発し、自社のクラウドサービスの一部で利用している他、そのリソースをクラウド経由でサードパーティーに開放している(参考記事)。

その技術を応用して開発されたのが、2017年10月に発表された「Google Clips」というカメラ(米国限定販売)。「ベストショット」で自動的にシャッターを切る機能や、被写体を学習して画角に入ると自動でピントを合わせる機能に、その成果が現れている。

これらの機能は、Clips本体内のチップがシーンや被写体を認識して実行される。クラウドの機械学習エンジンに頼ることはない。「(ユーザーの)プライバシーを重視」(アルカス氏)して、「Googleが写真を見ていない(データを受け取っていない)ことを担保する」(同)ためだ。現に、これらの機能はClipsがオフラインの状態でも使える。

Clipsの技術をさらに応用したのが、Pixel 3/Pixel 3 XLのカメラ。自撮りの際に笑顔や変顔を検出してシャッターを切る「フォトブース」機能や、シャッターを切る前後の写真も保持することでタイミングに起因する撮影失敗を回避する「トップショット」機能は、その典型例だ。ステッカーやキャプションなどをファインダーに挿入できる「Playground」、夜景モードや「超解像ズーム」にもオンデバイスAIが使われている。

これらの機能に必要な処理は本体内で完結するため、Clipsと同様にデバイスがオフラインの状態でも使える。

その他、カメラによる文字列・数字の認識機能や、流れている音楽を検索する「Now Playing(この曲何)」機能、電話着信時の応答をAIに任せ、相手の発話内容を文字起こしできる「Call Screen」機能(一部の国・地域のみ対応)にも、オンデバイスAIを利用している。

今後は「フェデレーションラーニング」に注力へ

先述のオンデバイスAIを利用する各種機能は、Pixel 3/Pixel 3 XL内部でモデルを蓄積して機械学習処理をしている。しかし、あくまで“自分だけ”で学習することになるため、学習精度の向上には限界がある。

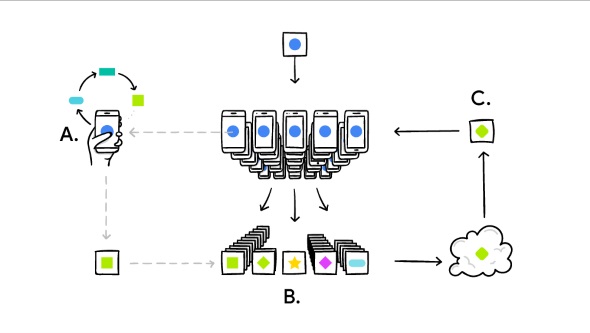

そこで、今後Googleでは「フェデレーションラーニング(Federated Learning)」という取り組みを強化する。

フェデレーションラーニングは直訳すると「連帯学習」という意味。通常の機械学習ではモデルデータを収集することで精度を高めていくが、フェデレーションラーニングではモデルデータの代わりにオンデバイスAIで蓄積した「改善情報」を収集する。

複数端末から改善情報を集めた後、それをもとに「共有(改善)モデル」を作成し、配信。オンデバイスAIに適用して学習を進め、新しい改善情報を……という手順を繰り返してオンデバイスAIの弱点を克服しようとしている。

このフェデレーションラーニングは現在、Android版「Gboard」アプリでテスト運用中。「充電中(電源接続中)」「Wi-Fi接続中」「待機中」の3条件がそろった時にのみ実行される。

ニュース解説番組「NEWS TV」で記事をピックアップ

ITmedia NEWS編集部がYouTubeでお届けするライブ番組「ITmedia NEWS TV」で、この記事を取り上げています。ぜひ視聴・チャンネル登録をお願いします。

関連記事

AIの力でデュアルカメラ超え? 「Pixel 3 XL」の“賢い”カメラの実力を見る

AIの力でデュアルカメラ超え? 「Pixel 3 XL」の“賢い”カメラの実力を見る

Google純正のスマートフォン「Pixel 3」「Pixel 3 XL」が日本に上陸。トレンドに逆らうようにアウトカメラはあえてシングルで、インカメラがデュアルという面白い構成。どんなものなのか、撮り試してみましょう。 「Pixel 3」「AQUOS zero」「Galaxy Note9」「Xperia XZ3」どれを買う? 特徴を総ざらい

「Pixel 3」「AQUOS zero」「Galaxy Note9」「Xperia XZ3」どれを買う? 特徴を総ざらい

2018年の秋冬スマートフォンが続々登場している。新機軸ではGoogleの「Pixel 3」、シャープの「AQUOS zero」が注目。従来の人気シリーズからは「Galaxy Note9」と「Xperia XZ3」が登場。今回は、これら4モデルの違いをチェックしていく。 ドコモとソフトバンクの「Pixel 3」「Pixel 3 XL」、価格はどちらが安い?

ドコモとソフトバンクの「Pixel 3」「Pixel 3 XL」、価格はどちらが安い?

ドコモとソフトバンクが扱う「Pixel 3」「Pixel 3 XL」の価格が出そろった。一括価格はGoogle版が最安だが、ドコモはMNPの割引きが手厚い。 Googleの目指す未来を詰め込んだスマホ 「Pixel 3 XL」先行レビュー

Googleの目指す未来を詰め込んだスマホ 「Pixel 3 XL」先行レビュー

Googleは11月1日に、自社社開発のスマートフォン「Pixel3」「Pixel 3 XL」を発売する。他メーカーが投入するAndroidスマホとは何が違うのか? デザインからソフトウェアまでをチェックした。 auの2018年秋冬モデルに「Pixel 3」「Pixel 3 XL」「AQUOS zero」がない理由

auの2018年秋冬モデルに「Pixel 3」「Pixel 3 XL」「AQUOS zero」がない理由

auが2018年秋冬モデルを発表した。そのラインアップには「Pixel 3」「Pixel 3 XL」や「AQUOS zero」がなかった。なぜなのか。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

アクセストップ10

- 「iPhoneのシェアの高いスマホ市場」に異変!? ショップ店員に聞く「Androidスマホ人気」の実情 (2026年02月27日)

- 3キャリアに聞く「Galaxy S26」戦略 「月1円」のソフトバンク、3年ぶり参戦の楽天、16周年のドコモ (2026年02月27日)

- 楽天モバイル回線のMVNOサービス「ゼロネオモバイル」登場 月額6248円でデータ無制限、60回払いで端末実質0円 (2026年02月25日)

- 5G通信とMagSafeをサポート! 片手でも持ちやすい「iPhone 12 mini(128GB)」のAmazon整備品が約3万円から (2026年02月26日)

- モバイルSuicaがいつの間にか“ゴールデン”に そして忘れられる“車窓” (2026年02月27日)

- ポケモンとYahoo! JAPANが30周年コラボ LINEも特別デザインに 検索画面に“赤・緑の3匹”が登場する演出も (2026年02月27日)

- 「Galaxy S26/S26+」発表、日本では5年ぶり「+」モデルも 新チップ搭載でカメラやAIの処理性能が向上 (2026年02月26日)

- 「eSIM」は人類にとって早すぎる? 携帯電話ショップ店員に聞いたら意外な答えが (2025年11月28日)

- 最上位モデル「Galaxy S26 Ultra」発表 のぞき見防止ディスプレイや明るいカメラ搭載 実機を写真で解説 (2026年02月26日)

- 「d払い」アプリ、データ読み込み中に支払いコードを表示可能に (2026年02月26日)