PCのベンチマーク至上主義はスマートフォンやタブレットに通用しない:本田雅一のクロスオーバーデジタル(1/2 ページ)

プロセッサ単体で製品の性能を予測するのは難しい

少し前の話になるが、2012年1月中旬に筆者と知人のTwitter上での会話がTogetter上にまとめられてフィーチャーされ、にわかに周囲が騒がしかったことがあった。やりとりそのものは2011年9月にされたもので、どちらかと言えば、街中で知人と会ったときに、カフェに立ち寄って世間話をしていた……という程度のものだ。

それが4カ月を経過し、急にTogetterへのリンクが多数SNSで流れた理由は、海外メディアでNVIDIA Tegra 3のあまり芳しくないベンチマークテスト結果が公表されたのが理由だった。

PCに投資をしてきた人たちの一部が、ハイエンドのタブレットへと興味を移し、クアッドコア+高性能GPUの組み合わせで高性能が期待できる(言い換えれば、高性能以外にはあまり期待することがない)Tegraの最新版に注目。ところがスペックの高さを感じさせない性能の低さ(実際には公表されたベンチマークテストの数値が低かったこと)に対し、「なんでこんなことに?」と話題になったのが原因だったようだ。

先の知人との会話内容は、単に「PC以外の世界では、プロセッサ単体の性能や機能だけで、製品の性能を予測するのは難しいよね」という、製品を作っている人たちにとっては当たり前の話だった。しかし、PCでのシンプルなベンチマーク競争に慣れてきた人には、新鮮な話だったらしい。

ベンチマークテストとは、性能を評価するための物差しでしかない。物差しには単位があり、その数字に意味を持たせようとする。しかし、評価すべき対象が一筋縄ではいかないようなものの場合、それを“分かりやすく解読できるよう”に単純化を行う。つまり、何らかの意思がそこに入り込み、ベンチマークの数値が性能評価の物差しとして正しく認識できるよう調整を行うことが多い。

一方でベンチマークテストを絶対的な物差しとして見ている人もいるだろう。実際、絶対的な物差しとして数値を評価できるよう意識したベンチマークもあるが、今度は数値の評価に専門的な知識が必要になる。

今回はこの辺りの話をしようと思うが、PCの性能評価は歴史的にもベンチマークテストのあり方が模索され、テストをする側もされる側も、それらのデータを読み取る側もノウハウを蓄積している。しかし、スマートフォンやタブレットの性能評価は、もっと複雑な要素が絡み合う。

両者の大まかな違いを、2012 International CESでのデモや、その後の関係者へのヒアリングで出てきたMedfield(開発コード名 ※インテルのスマートフォン/タブレット向け次世代Atomプロセッサ)の話を交えながら書き進めていこう。

PC業界における性能評価の変遷

PCでベンチマークテストが持てはやされるようになったのは、主にWindowsが普及して以降のことだ。プロセッサだけでなく、グラフィックスの性能が求められるようになり、さらにはWindowsによって各種グラフィックスチップを簡単に入れ替えられるようになり、どのような性能の違いがあるかを分析しなければ、正しい買い物ができなくなってしまった。

すでにPC好きにとってはごく当たり前のことだが、クロック周波数が速くとも中の構造が違えば性能は違うこと(今ではコア数や同時に走るスレッド数などのパラメータもある)、プロセッサだけ高速でもI/O速度が遅ければ意味がないこと、グラフィックスはアクセラレータ(今のようにプロセッサとは言えないものだった)単体の性能では決まらないこと、などは、ひとつひとつ丁寧に説明しなければならなかった。その上で、評価で動かしたプログラムの動作を理解、分析しなければ違いを正しく説明できない。

しかし、2つの理由からPCの性能評価は、少なくとも表面上はシンプルなものだと誤解を受けてきたと思う。

まず1つめの理由だが、かつては性能向上のペースがあまりに速かったため、細かなシステム評価を行っているうちに、より高クロック動作の製品が出てくる。あるいは新しいグラフィックスチップを搭載した拡張カードがどんどん出てくるので、さっさと新しいものに交換してしまった方がいい、なんてことになってしまったからだ。

もちろん、3Dグラフィックスなどは実行する機能とパフォーマンスの関係などを細かく評価するのだが、あまり細かなところに落とし込みすぎると、読者の幅が極めて狭くなっていく。そこで、PC業界は長い時間をかけて、複雑な性能評価を“単純な数値に落とし込んで考えること”を世の中に教育してきた。これがもう1つの理由だ。

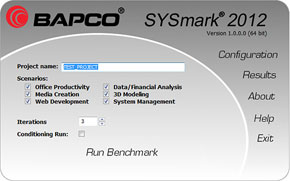

例えば、業界団体のBAPCo(Business Applications Performance Corporation)が提供するベンチマークテスト用ソフトウェア「SYSmark」などがそれにあたる。x86命令の高速化こそがプロセッサ性能を示す指標であった時代に、新しい命令セットなど一直線の指標では比較できない要素が出てきたとき、インテルは積極的にBAPCoのリリースする業界標準ベンチマークテストの普及活動をした。

新しい命令セット、新しいアーキテクチャによる高性能化、あるいはシステムアーキテクチャの変化に伴う性能評価の見直しなどが、その時代に合わせて行われてきたのだ。新しいアプリケーション、PCの使い方が生まれた場合も同様に盛り込まれ、ソフトウェア技術のトレンドが反映される。

命令セットなど新アーキテクチャへの対応はFuturemarkのベンチマークテスト用ソフトウェアである「PCMark」や「3DMark」なども同じだが、これらが基本的にPCのハードウェアに密接に関係する部分的な性能を計測するのに対し、SYSmarkはシステム全体の性能をさまざまな重み付けを交えて総合評価するという点で大きく異なる。

2011年にAMDがBAPCoから脱退した(NVIDIAやVIA Technologiesも脱退している)のも、コンピュータのトレンドに対する解釈がBAPCoの主流意見と合わなかったからだ。AMDはGPUの位置付けが大きくなり、GPUがPCの総合性能に与える影響が大きいと考えていたが、BAPCoはCPU性能の絶対性を重視する傾向が強い。

それだけベンチマークと、コンピュータのアーキテクチャの関連性が高いということだ。ベンチマークの内容や評価手法は、すでに複雑怪奇で一般に理解しがたいものになっており、プロセッサコアの増加、GPUの演算器構造の柔軟性が高まっていることなどと合わせ、業界全体で指標をコントロールしていかなければ目安を出せないのだが、プロセッサベンダーとして進む方向が異なると、ベンチマークをどう設計すべきかで話がこじれてしまう。

筆者はベンチマークテストに対し、あるときから急速に興味を失ったこともあり、ごくたまにしか参加はしていないが、新たなプロセッサアーキテクチャが登場すると、その度にプロセッサベンダーは、性能指標がなぜ変化するのか、ベンチマークテストで出ている指標の変化をどう読み取るべきなのか、といったレクチャーを行う(そのままレクチャー通りに伝えるという意味ではない。あくまでプロセッサベンダー側の言い分を聞くというスタンスだ)。

ときにこのやり方は議論を招くこともある。新たな命令セットやアーキテクチャの違いを評価に加える場合、どの程度、その効果を指標に見込むべきなのかについて、プロセッサベンダーが関わることに疑念を抱く向きもあるからだ。また、ここ数年で言えばGPUを3Dグラフィックス以外にも使うようになってきた。CPUとGPUを個々に評価する場合は別として、システム全体の性能を考えるときに、CPUとGPUをどのようなバランスで評価すべきかは難しい問題だ。

しかし、いくつかの問題はあるものの、大局的にみてベンチマークテストに関連したマーケティングプランは、PCという枠組みの中でうまく機能していると思う。インテルを中心としたプロセッサベンダーのマーケティングプログラム、また自作PCマニアを中心としたユーザー側の理解しようとする努力のかいもあって、PCの性能評価は“比較的”シンプルなものとして受け取ってもらうことに成功してきたと思う。

ところが、スマートフォンの世界で、同じような仕組みを持ち込むことは難しいだろう。特にAndroidスマートフォンやタブレットの性能評価は常々難しい。インテルがGoogleと提携し、Medfieldの投入でAndroid端末の市場に参入したことで、複数の命令アーキテクチャが混在する状況になったうえ、同じARMアーキテクチャでもGPUとの組み合わせや、組み合わせるコプロセッサ、そしてそれらの“使い方”で性能が変化してしまうからだ。

さらに、そこに消費電力というファクターが入ってくると、より複雑になっていく。

関連キーワード

ベンチマーク | テスト | Medfield | スマートフォン | Intel | ARM | CPU | Tegra | CES | ARROWS Z ISW11F | Tegra 3 | NVIDIA | VIA Technologies | Atom | OMAP | Androidタブレット | 本田雅一のクロスオーバーデジタル | Texas Instruments

Copyright © ITmedia, Inc. All Rights Reserved.

アクセストップ10

- 改めて考える単眼カメラとモノラルスピーカー それでも「iPhone Air」を推したくなる理由 (2026年02月09日)

- 6500円でデスクに新風! Thermalrightの小型液晶がヒット、背景にメモリ高騰? (2026年02月09日)

- 32GBメモリが6万円切り、2TB SSDは3.3万円から 価格上昇が続くアキバで見つけた高コスパパーツ (2026年02月07日)

- ソニーが「Blu-ray Discレコーダー」の出荷と開発を終了 代替の録画手段はある? (2026年02月09日)

- アドビが「Animateの販売終了」を撤回/メモリ高騰を受けRaspberry Piの一部モデルが再値上げ (2026年02月08日)

- ソニー、PCゲーマー向けの「DualSense」を3月5日に発売 USBケーブル付属 (2026年02月09日)

- スパコン「富岳」×モーションキャプチャで見えた金メダルへの「空気のつかみ方」 (2026年02月08日)

- ソニーとTCLの合弁が意味する「新しいソニー」の完成形――ソニーが“家電企業”の殻を脱いだ日 (2026年02月06日)

- JIS配列の2つ折りキーボード「Ewin 折りたたみ Bluetooth キーボード」が32%オフの2699円に (2026年02月06日)

- カプセルトイ「手のひらネットワーク機器」に第4弾モデル (2026年02月09日)