スマートグラス、3Dカメラ、ロボット――Qualcommの「Snapdragon」が目指す新しい世界:Uplinq 2014(2/2 ページ)

プロセッサの進化で何が可能になるのか?

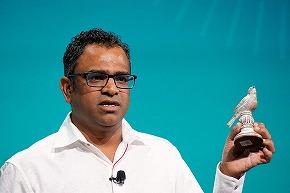

Uplinq初日の基調講演後半では、Qualcomm Technologies製品マネジメント担当SVPのRaj Talluri氏が登場し、Snapdragonを利用した応用事例の数々を紹介した。こうした応用事例におけるポイントの1つは、「処理性能の向上でできることが増えたこと」。応用技術を可能にする技術開発もさることながら、Talluri氏が「Yesterday's beyond is real.」というように、昨日までの越えるべき壁がプロセッサ技術の進化で今日ではすでに可能になっている。

Snapdragonファミリーを紹介。すべてのラインで4G接続機能を提供していく(写真=左)。モバイルの進化の速さを象徴するのが「Yesterday's beyond is real.」というフレーズ。今回のUplinqイベントを象徴する言葉だ(写真=右)

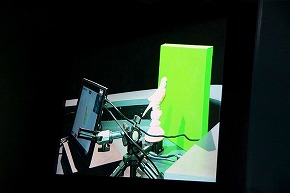

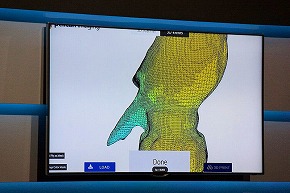

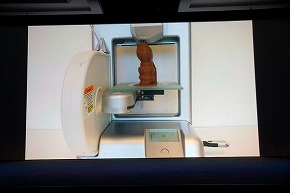

Snapdragonファミリーを紹介。すべてのラインで4G接続機能を提供していく(写真=左)。モバイルの進化の速さを象徴するのが「Yesterday's beyond is real.」というフレーズ。今回のUplinqイベントを象徴する言葉だ(写真=右)典型的なものの1つが3Dカメラ技術で、単純に2つのカメラ撮影による立体視だけではなく、目の前に映る物体の奥行きや距離までを認識可能にする技術だ。MicrosoftがKinectで採用したPrimeSenseの技術が有名だが(同社は後にAppleが買収)、通常の2Dカメラに加え、映像の“奥行き”を測る「深度センサー」を別途搭載し、両者の映像を組み合わせて目の前の“像”の立体構造をコンピュータが認識する。ただ、これでは一方向からの映像に過ぎないため、さらにターゲットとする物体の周囲をカメラで撮影することで、物体全体の構造を理解し、3Dプリンタでそのまま出力が可能なモデルデータを取得する。

同種の技術やデモはUplinqの前週にサンフランシスコで開催されたIDFでIntelが「RealSense Snapshot」として紹介しているが、Qualcommのデモではそれとは異なる「Pelican Imaging」の技術を用いている。SnapdragonのリファレンスデザインであるQRDのタブレットに16個の小さなイメージセンサーから成るカメラを搭載し、3D撮影を行う。このイメージセンサーから得られた情報をコンピュータ処理で解析することで、前述の2Dカメラ+深度センサーと同様のデータを得られる。

物体を3Dセンサー搭載のタブレットで3Dスキャニングを行い、立体の格子データを生成して3Dプリンターで出力する。もちろん、出力には時間がかかるため、最後の部分だけはあらかじめ撮影したビデオを早まわしで再現していた

物体を3Dセンサー搭載のタブレットで3Dスキャニングを行い、立体の格子データを生成して3Dプリンターで出力する。もちろん、出力には時間がかかるため、最後の部分だけはあらかじめ撮影したビデオを早まわしで再現していたこうした処理が持ち運び可能なタブレットで実現できるのも、近年プロセッサの処理能力が大幅に向上したことが背景にある。これとは別に、Qualcommが出資するMantis Visionの3Dカメラ技術「MV4D」も紹介された。Mantis Visionの技術は前述RealSenseと同じ、赤外線照射で物体の奥行きを測る深度センサーを搭載する方式で、Pelican Imagingのものとは異なる。

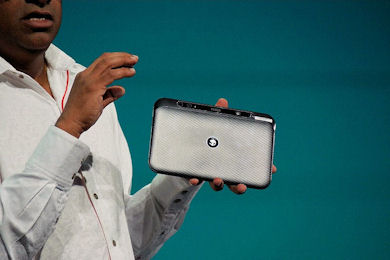

このほか、Snapdragonの応用例としてShazamの音楽認識技術のデモも披露された。ShazamはAppleがiOS 8で採用して話題となったが、いま流れている曲名が何かを膨大な音楽ライブラリとマッチングさせて検索を行う技術だ。街中で、カフェで、テレビで……など、ふと耳に入った音楽が何かを知りたいというシーンは多いだろう。これをスマートフォンなどを使ってデータベースへの参照が可能な形へとリアルタイム変換し、曲名をクラウド上から引き出すという一連の操作に、プロセッサパワーは無縁ではない。これも処理能力向上とともにできることが増えた証左の1つだ。

そして今回、次世代のフラッグシップとなる「Snapdragon 810」プロセッサが紹介された。同シリーズとしては初の64ビットプロセッサで、2015年前半での製品出荷を目指している。概要自体は今年のComputex 2014で紹介され、今回も機能の詳細については公表されなかったものの、初となる実動作デモが披露されている。車をリアルタイムレンダリングするデモで、色や光源の変更を施しても即座にそれが反映され、これがリアルタイムによるレンダリングであることを証明しているという。おそらく、2015年1月のCESのタイミングには、より詳細な機能紹介を含めてさまざまなデモが披露されるだろう。

製品概要自体はすでに発表されている64ビット対応プロセッサの「Snapdragon 810シリーズ」だが、今回のUplinqで初めてライブデモが公開されている。物体をリアルタイムでレンダリングするデモで、配色やライティングを変更しても、それがすぐに映像に反映されるのを示すことで、これがプリレンダリングではないことを証明している

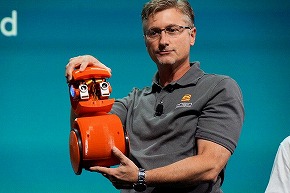

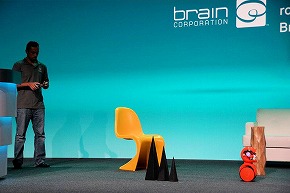

製品概要自体はすでに発表されている64ビット対応プロセッサの「Snapdragon 810シリーズ」だが、今回のUplinqで初めてライブデモが公開されている。物体をリアルタイムでレンダリングするデモで、配色やライティングを変更しても、それがすぐに映像に反映されるのを示すことで、これがプリレンダリングではないことを証明している講演の最後に、Snapdragonを搭載したBrain Corporationのミニロボットが紹介された。先ほどのMicro Roverと被る部分もあるが、こちらは「学習機能」に重点を置いている点で異なる。例えば、障害物が多数配置されたエリアを一定のルートで移動するようリモートコントロールで何度か移動させていると、ロボットはあるタイミングでそれを学習し、同じルートを自動で動けるようになる。また、正面に搭載されたカメラで人のモーションを認識できるようになっており、これを使って“ペット”のように人が手のモーションでロボットの動きを制御できたりと、非常に自然でスムーズな反応を見せる。技術の進化のすごさを垣間見た瞬間だった。

ロボットは学習機能を持っている。目の色が青や赤の状態のときは、リモートコントロールで操作されて、障害物を指示通りに避けながら移動するだけだが、一度学習が完了すると目の色が緑に変化し、学習したルート通りに自身で移動できるようになる

ロボットは学習機能を持っている。目の色が青や赤の状態のときは、リモートコントロールで操作されて、障害物を指示通りに避けながら移動するだけだが、一度学習が完了すると目の色が緑に変化し、学習したルート通りに自身で移動できるようになる

目の前の人間のモーションを学習することも可能だ。例えば「片手を前に掲げると“後退”」「両手で手招きすると“前進”」という形でモーションとリモートコントロールを組み合わせながら学習させると、まるで生きているかのように自然な動きで挙動を制御できる

目の前の人間のモーションを学習することも可能だ。例えば「片手を前に掲げると“後退”」「両手で手招きすると“前進”」という形でモーションとリモートコントロールを組み合わせながら学習させると、まるで生きているかのように自然な動きで挙動を制御できる関連キーワード

Snapdragon | ロボット開発 | QUALCOMM(クアルコム) | リアルタイム | Shazam | 3Dカメラ | 3Dプリンタ | Apple | 2014 CES | 64ビット | Intel Developer Forum | Intel | iOS 8 | Microsoft | Kinect for Xbox 360

関連記事

Qualcomm、64ビットの「Snapdragon 810/808」を発表

Qualcomm、64ビットの「Snapdragon 810/808」を発表

Qualcommのモバイル向けハイエンドプロセッサ「Snapdragon 800」シリーズの次世代モデルは64ビットとLTE(Cat 6)をサポートし、上位の「810」は4K解像度に対応する。 スマホ/タブレットにも64ビットの波、IntelがMerrifield&Moorefield発表――下り300MbpsのLTE Advancedチップも

スマホ/タブレットにも64ビットの波、IntelがMerrifield&Moorefield発表――下り300MbpsのLTE Advancedチップも

米Intelは、Mobile World Congress 2014に先立ち、新製品に関する記者説明会を開催。新Atomプロセッサーや下り300MpbsのLTE Advanced Cat 6に対応した新モデムチップなどを発表した。 2014 International CES:「動く! Snapdragon 805」に「抗菌! Gorilla Glass」

2014 International CES:「動く! Snapdragon 805」に「抗菌! Gorilla Glass」

これまでは「小さいものならまかせておけ」のQualcommだったが、これからは「大きなものもまかせてくれ」とアピールしている。 “1000元”スマートフォン向け「Snapdragon 410」発表

“1000元”スマートフォン向け「Snapdragon 410」発表

クアルコムは、12月10日に「Snapdragon 410」を発表した。低価格モデルへの採用を想定したモバイルプロセッサで、搭載製品は2014年後半に登場する予定だ。 Snapdragon 800 Workshop in 北京:Snapdragon 800シリーズ搭載MDPsでベンチマークテストをやってみちゃう

Snapdragon 800 Workshop in 北京:Snapdragon 800シリーズ搭載MDPsでベンチマークテストをやってみちゃう

2013年後半に登場予定の「Snapdragon 800」シリーズは、従来モデルから大幅に性能が向上するという。その言葉は、“真実”なのか、“はったり”なのか。 Qualcomm、Snapdragon 800で向上した性能をアピール

Qualcomm、Snapdragon 800で向上した性能をアピール

Snapdragon 800シリーズの性能を実際に体感するQualcommのワークショップ。訴求するのは格段に向上した“グラフィックス性能”と“LTE Advanced”だ。 Qualcomm Mobile Benchmarking Workshop:クアッドコアCPU搭載のSnapdragon「APQ8064」のベンチマークを試す――Tegra 3との差は?

Qualcomm Mobile Benchmarking Workshop:クアッドコアCPU搭載のSnapdragon「APQ8064」のベンチマークを試す――Tegra 3との差は?

スマホやタブレットにおける「クアッドコアCPU」といえば、NVIDIAの「Tegra 3」が話題を集めているが、QualcommもクアッドコアCPU搭載のプロセッサーを開発しており、2012年内には採用製品が登場する見込み。Qualcommが開催した「Benchmarking Workshop」でその性能を確認した。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

アクセストップ10

- 6500円でデスクに新風! Thermalrightの小型液晶がヒット、背景にメモリ高騰? (2026年02月09日)

- 改めて考える単眼カメラとモノラルスピーカー それでも「iPhone Air」を推したくなる理由 (2026年02月09日)

- 32GBメモリが6万円切り、2TB SSDは3.3万円から 価格上昇が続くアキバで見つけた高コスパパーツ (2026年02月07日)

- ソニーが「Blu-ray Discレコーダー」の出荷と開発を終了 代替の録画手段はある? (2026年02月09日)

- ソニー、PCゲーマー向けの「DualSense」を3月5日に発売 USBケーブル付属 (2026年02月09日)

- アドビが「Animateの販売終了」を撤回/メモリ高騰を受けRaspberry Piの一部モデルが再値上げ (2026年02月08日)

- スパコン「富岳」×モーションキャプチャで見えた金メダルへの「空気のつかみ方」 (2026年02月08日)

- ソニーとTCLの合弁が意味する「新しいソニー」の完成形――ソニーが“家電企業”の殻を脱いだ日 (2026年02月06日)

- カプセルトイ「手のひらネットワーク機器」に第4弾モデル (2026年02月09日)

- AYANEO、Ryzen AIを搭載した7型WindowsポータブルゲーミングPC「KONKR FIT」を発表 (2026年02月09日)