Microsoftが「会話Bot」に力を注ぐ理由:Build 2016(3/3 ページ)

認識コンピューティングの先にあるもの

IBMではWatsonを紹介するにあたって「Cognitive Computing(認識コンピューティング)」という表現を使っている。コンピュータが問い合わせを理解し、それに対して適切な回答を返すという仕組みだ。よく「AI(Artificial Intelligence)」というキーワードがこの周辺で用いられているが、筆者の認識ではWatsonやMicrosoftが今回発表した一連の仕組みは、いわゆるAIとは違うものだと考えている。

AIでは自ら意志を持って決定するが、WatsonやMicrosoftの自然言語インタフェースは「問い合わせに対して適切な処理」を行う仕組みであり、コンピュータ側にとって何らかの意志が介在する余地はない。厳密にはプログラミング次第と考えられるが、現在想定されているサービスの数々は「コンピュータによる自動処理」という域を出ていない。

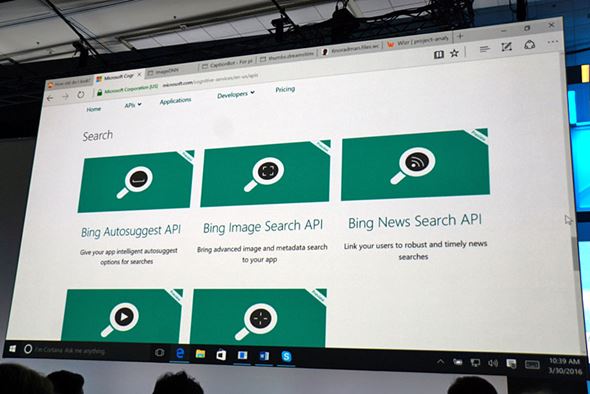

意志が介在しないとはいえ、こうしたBotの仕組みは自然言語処理だけでなく、工夫次第でさまざまな機能強化が可能だ。Microsoftが提供しているCognitive ServicesのAPIを活用することで、BotにさまざまなCognitive(認識)機能を付与できるようになる。

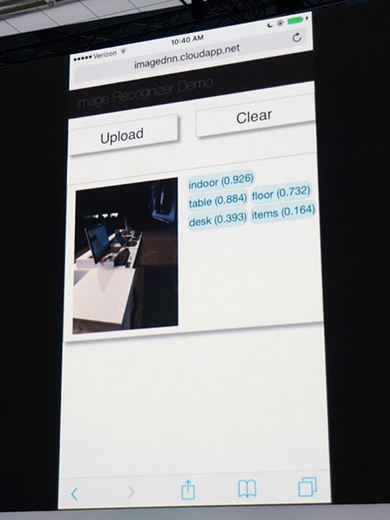

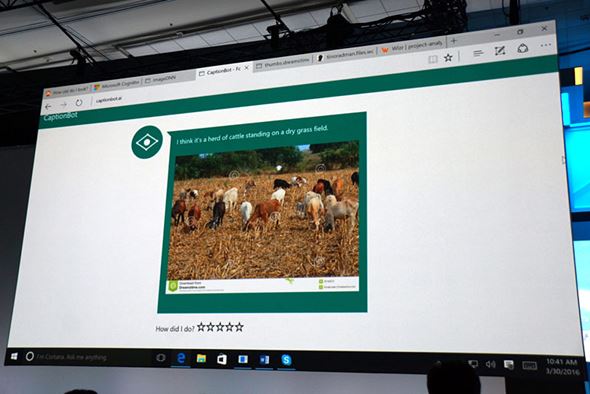

例えば画像認識のAPIを追加することで、カメラや写真に写る映像を解析してその内容を理解し、音声認識のAPIを利用することで、普通の人間よりも正確に多人数の会話を聞き取ることができる。このCognitiveなAPI群は、特にCortana型のパーソナルアシスタント機能で大きな効力を発揮するだろう。

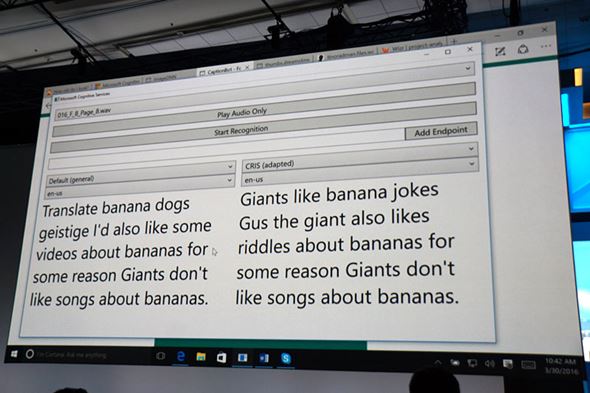

音声認識APIでは、複数人の音声会話を自動的に認識してテキスト化(キャプション化)することが可能になる。複数人が同時にしゃべっていたとしても、問題なく内容を聞き取って、まるで聖徳太子のように結果を返してくれる

音声認識APIでは、複数人の音声会話を自動的に認識してテキスト化(キャプション化)することが可能になる。複数人が同時にしゃべっていたとしても、問題なく内容を聞き取って、まるで聖徳太子のように結果を返してくれる米Microsoftのサティア・ナデラCEOとともにBuild 2016の基調講演に登場したのは、同社ロンドン拠点のBingチームエンジニアであるシャキーブ・シャイク氏だ。同氏は視力にハンディキャップを抱えており、もしこれらのCognitiveなAPI群を活用したアプリケーションで視力を補うことができれば、日常生活がより便利になるという紹介ビデオが会場で流された。このようにBot FrameworkとCognitive Servicesの組み合わせは、非常に大きな可能性を秘めた仕組みだ。

興味深いのは、自然言語処理と認識型APIともに、中国の北京に拠点を置くMicrosoft Research Asia(MSRA)での研究成果がベースとなっていることだ。その成果については過去の連載記事でも紹介したが、MSRAは将来のMicrosoftを担う重要な基盤となりつつあるのかもしれない。

技術のさらなる進化と合わせて、その応用例としてサードパーティーの興味深いアプリケーションがどれだけ出てくるのか、今後1〜2年先の動向を見守っていきたい。

←・前回記事:Windows 7時代のアプリを「10」対応にするメリットは?

- Apple M1/M2対抗の「Oryon」はWindows on Armの流れを変えるか

- Windows 10は全て64bitになる 32bitから64bitへの完全移行は間もなく

- Windows 10のアップデートが新型コロナの影響で大きく変わる

- Surface Neoは間に合わない!? 2020年に登場するMicrosoftの新ハードウェア

- 登場から4年がたち、Windows 8時代の資産から脱却しつつあるWindows 10

- 2020年、Microsoftが目指すパスワードレスの旅

- 「モノ」を売る場所から「体験」と「ソリューション」の場に変化するMicrosoft Store

- AIやビッグデータとともに進化する「Microsoft Teams」の今 一歩先行くオフィス環境

- Microsoftが折りたたみ型Surfaceを開発中? うわさを巡る最新事情

- 新型Surface Proで互換性は維持される? 2019年の次世代モデルを予測する

関連キーワード

Microsoft | Cortana | API | NUI(Natural User Interface) | Skype | ユーザーインタフェース | Windows | Cognitive Computing | Windows 10 | 鈴木淳也の「Windowsフロントライン」

関連記事

Build 2016:Windows 7時代のアプリを「10」対応にするメリットは?

Build 2016:Windows 7時代のアプリを「10」対応にするメリットは?

Windows 10世代のモダンなアプリより、Windows 7以前のデスクトップアプリを好んで使っているユーザーは少なくないだろう。Microsoftはそんな旧世代アプリのモダン化を訴えているが、どのようなメリットが得られるのだろうか。 Build 2016:Windows 10公開から1年後の姿はどうなる?

Build 2016:Windows 10公開から1年後の姿はどうなる?

2016年も始まった米Microsoftの開発者会議「Build」。幅広いPCユーザーに関係するWindows 10次期大型アップデートとUWPアプリの今後について新情報が次々と発表された。 本田雅一のクロスオーバーデジタル:「コンピュータとの会話が日常になる未来」を示したMicrosoft

本田雅一のクロスオーバーデジタル:「コンピュータとの会話が日常になる未来」を示したMicrosoft

世界的に人工知能が注目を集める中、Microsoftが開発者会議で示した未来のコンピューティング像は「ハードウェアに依存しない、会話でさまざまな問題がスマートに解決する世界」だった。 鈴木淳也の「Windowsフロントライン」:Windows 10の次はどうなる? Microsoft開発者会議「Build 2016」は日本時間3月31日0時30分から

鈴木淳也の「Windowsフロントライン」:Windows 10の次はどうなる? Microsoft開発者会議「Build 2016」は日本時間3月31日0時30分から

Microsoft開発者会議「Build 2016」は間もなく開催。会場前の盛り上がりとイベントの見どころをお伝えする。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

アクセストップ10

- 6500円でデスクに新風! Thermalrightの小型液晶がヒット、背景にメモリ高騰? (2026年02月09日)

- 新ARグラス「XREAL 1S」を試す 解像度と輝度が向上、BOSEサウンドで没入感アップ “3D変換”も大きな魅力 (2026年02月10日)

- 元Appleのジョナサン・アイブが手掛けるフェラーリ初EVの内装デザイン公開 物理ボタンとデジタルの融合 (2026年02月10日)

- ソニーが「Blu-ray Discレコーダー」の出荷と開発を終了 代替の録画手段はある? (2026年02月09日)

- 32GBメモリが6万円切り、2TB SSDは3.3万円から 価格上昇が続くアキバで見つけた高コスパパーツ (2026年02月07日)

- マウス社長が3日間“フル参戦”した理由とは? 大阪・梅田のど真ん中で起きた“eスポーツ×地域振興”の化学反応 (2026年02月11日)

- ASRock、“CPU起動トラブルを解決”するSocket AM5マザー用のβ版BIOSを公開 (2026年02月10日)

- もはや「光モノ」とは呼べない時代に――Corsairのタッチ液晶登場も即レア化 (2025年11月03日)

- PFU、HHKBをオプション付きでお得に買える「HHKBスターターキット」を期間限定で発売 (2026年02月10日)

- 梅田の街がeスポーツに染まった3日間――「Osaka GeN Scramble」で見えた、地域とデバイスが融合する最新イベントの形 (2026年02月10日)